영상에서 사람의 감정을 인식해야 하는 상황이 생겼다.

정확도가 아주 높을 필요는 없었고, “대략적인 분위기”만 파악하면 되는 목적이었다.

그래서 처음에는 비교적 접근이 쉬운 Python 기반 감정 인식 모델부터 살펴보게 됐다.

자료를 찾아보면 이미 잘 정리된 예제도 많고,

웹캠 하나만 있으면 바로 동작하는 것처럼 보였다.

솔직히 말하면, 시작하기 전까지는 그렇게 복잡한 작업일 거라고 생각하지 않았다.

막상 해보니 생각보다 고려해야 할 부분이 많았다.

시작 전에 기대했던 것과 실제의 차이

문서나 예제에서는 감정 인식이 꽤 단순해 보였다.

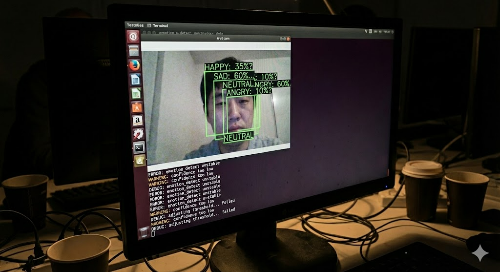

프레임을 받아서 얼굴을 검출하고, 감정 클래스를 예측하는 구조였다.

속도나 정확도도 어느 정도는 보장되는 느낌이었다.

하지만 실제 영상 환경에서는 상황이 달랐다.

조명, 얼굴 각도, 표정 변화가 조금만 달라져도 결과가 흔들렸다.

의외로 “잘 나올 때만 잘 나오는” 경우가 많았다.

이 시점에서,

이게 과연 실사용에 바로 쓸 수 있는 수준인지 고민이 생기기 시작했다.

실습 과정에서 가장 먼저 막혔던 지점

가장 먼저 시간을 잡아먹은 건 영상 프레임 처리였다.

정적인 이미지가 아니라 연속된 영상이다 보니,

프레임 단위로 처리하는 과정에서 지연이 쉽게 발생했다.

또 하나는 디버깅이었다.

감정 분류 결과가 틀렸을 때,

이게 모델 문제인지, 입력 데이터 문제인지 바로 판단하기 어려웠다.

“여기서 뭔가 잘못된 것 같다”는 느낌은 드는데,

명확하게 짚어내기는 쉽지 않았다.

이 부분에서 생각보다 많은 시간을 쓰게 됐다.

감정 인식 모델을 쓰면서 애매했던 부분들

장점만 놓고 보면 분명 매력적이다.

하지만 실습하면서 애매하다고 느낀 점도 적지 않았다.

예를 들면,

- 감정 클래스가 현실과 잘 맞지 않는 경우

- 중립 표정에서도 감정이 과하게 분류되는 현상

- 사람마다 결과 편차가 꽤 큰 점

이건 아직도 명확한 해답을 찾지 못했다.

모델을 바꾸면 나아질 수도 있겠지만,

완전히 해결될 문제는 아닌 것 같다는 생각도 들었다.

왜 Python 기반 접근을 선택했는지

사실 다른 선택지도 있었다.

상용 API를 쓰거나, 모바일 쪽으로 바로 가는 방법도 고려했다.

다만 이번에는

빠르게 실험하고, 구조를 이해하는 게 목적이었기 때문에

Python이 가장 현실적인 선택이었다.

완벽해서 선택했다기보다는,

지금 상황에서 가장 덜 부담스러운 쪽을 고른 느낌에 가깝다.

다시 한다면 다른 방향을 검토할 수도 있을 것 같다.

지금 시점에서의 개인적인 정리

이 방식이 잘 맞는 경우도 분명 있다.

프로토타입이나 연구용으로는 충분히 의미가 있다.

다만 실제 서비스나 현장 적용을 생각하면,

보완해야 할 부분이 아직 많다는 게 솔직한 판단이다.

특히 “정확도에 대한 기대치”를 어디에 두느냐가 중요해 보였다.

마무리하며

영상 기반 감정 인식은 생각보다 단순하지 않았다.

아직도 애매한 부분이 남아 있고,

더 나은 접근 방식이 있을 것 같다는 생각도 든다.

다만 이번 실습을 통해

“이 방식의 한계가 어디까지인지”는 어느 정도 감이 잡혔다.

지금 상황에서는, 이 정도가 현실적인 결과였다고 정리하고 있다.

이 실습을 통해 무엇이 잘 안 됐는지, 그리고 어떤 조건에서 이런 한계가 생기는지를 조금 더 분명히 알게 되었다.

'Computer Vision + Python > 산업 응용 & 비즈니스활용 (전문가)' 카테고리의 다른 글

| Python으로 구현한 상품 수집 서버 실시간 로그 분석 및 자동 알림 시스템 (0) | 2026.01.26 |

|---|---|

| 실제 모바일 영상 처리 실습에서 느낀 한계와 TensorFlow Lite 적용 후기 (0) | 2026.01.18 |

| Python으로 AR 기반 상품 시각화를 시도하며 느낀 현실적인 한계 (0) | 2026.01.10 |

| Python으로 드론/로봇 영상에서 실시간 지형 분석(Terrain Analysis) (0) | 2026.01.09 |

| Python으로 열화상(Thermal Imaging) 분석 – 보안/산업 응용 (0) | 2026.01.07 |