📌 서론: 하이퍼파라미터가 중요한 이유

머신러닝 모델의 성능을 좌우하는 요소는 크게 두 가지로 나뉩니다. 하나는 데이터 품질이며, 다른 하나는 모델 구조 및 하이퍼파라미터 설정입니다.

특히 하이퍼파라미터는 모델 학습 전 사전에 설정해야 하는 값으로, 모델의 수렴 속도와 예측 정확도, 일반화 능력에 직접적인 영향을 미칩니다.

딥러닝이나 트리 기반 모델에서 하이퍼파라미터가 잘못 설정되면 **과적합(Overfitting)**이나 **과소적합(Underfitting)**을 초래할 수 있으며, 동일한 데이터에서도 결과가 완전히 달라질 수 있습니다.

따라서 효과적인 하이퍼파라미터 튜닝 전략은 모델 최적화 과정에서 필수적인 작업입니다.

🔍 하이퍼파라미터란 무엇인가?

하이퍼파라미터(Hyperparameter)는 학습 전에 사용자가 설정하는 값으로, 모델이 데이터를 학습하는 방식 자체를 제어합니다.

이는 학습 중 자동으로 조정되는 파라미터(예: 가중치, 바이어스)와는 다릅니다.

대표적인 하이퍼파라미터 예시

- 학습률(Learning Rate): 파라미터를 얼마나 빠르게 업데이트할 것인가

- 에포크(Epoch): 전체 데이터를 몇 번 반복 학습할 것인가

- 배치 사이즈(Batch Size): 한 번에 학습에 사용할 데이터 수

- 트리의 깊이(Max Depth): 의사결정트리 기반 모델의 복잡도 제어

- 정규화 계수(L2, L1 등): 과적합 방지를 위한 규제 요소

각 모델마다 하이퍼파라미터 종류는 다르지만, 이들의 적절한 설정은 모델 성능 향상에 매우 중요합니다.

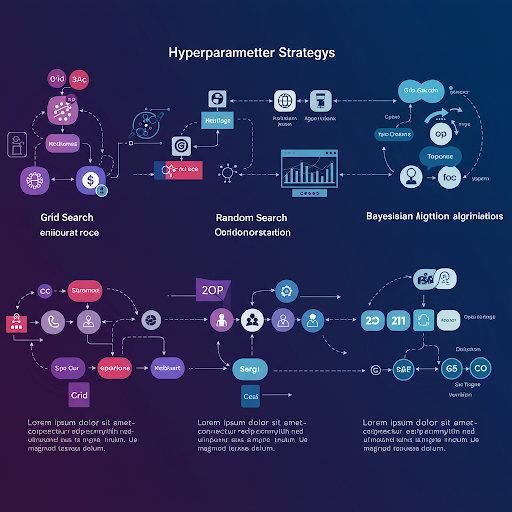

⚙️ 하이퍼파라미터 튜닝 전략의 유형

1. 그리드 서치(Grid Search)

가장 기본적인 방법으로, 모든 가능한 하이퍼파라미터 조합을 시도해 최적의 결과를 찾는 방식입니다.

예를 들어, learning_rate=[0.001, 0.01, 0.1], batch_size=[16, 32, 64]라면 총 9가지 조합을 모두 테스트합니다.

- 장점: 탐색 범위 내에서 최적 조합을 보장

- 단점: 조합 수가 많아질수록 계산량이 급격히 증가 → 비용이 큼

2. 랜덤 서치(Random Search)

하이퍼파라미터 조합 중 일부를 무작위로 선택하여 시도하는 방법입니다.

경험적으로, 전체 조합을 시도하는 것보다 적은 연산으로 유사하거나 더 나은 성능을 보일 수 있습니다.

- 장점: 계산 효율 우수, 고차원 공간에 유리

- 단점: 운에 따라 최적 조합을 놓칠 수도 있음

3. 베이지안 최적화(Bayesian Optimization)

이전 시도 결과를 기반으로 가장 유망한 영역을 중심으로 탐색합니다.

확률 모델을 사용하여 기대 성능이 높은 하이퍼파라미터 조합을 예측합니다.

- 장점: 시도 횟수를 줄이고도 높은 성능 확보

- 단점: 구현이 복잡하며 특정 라이브러리가 필요함 (예: Hyperopt, Optuna)

4. 진화 알고리즘(Evolutionary Search)

유전 알고리즘을 기반으로 선택, 교차, 돌연변이 등 진화 과정을 적용하여 최적의 하이퍼파라미터 조합을 찾습니다.

- 장점: 전역 최적화 능력이 뛰어남

- 단점: 계산량이 크고 파라미터 튜닝 자체가 필요함

5. 자동 머신러닝(AutoML)

Google의 AutoML, H2O, TPOT, Auto-sklearn 등은 하이퍼파라미터 튜닝뿐만 아니라 모델 선택 및 전처리까지 자동으로 수행합니다.

- 장점: 비전문가도 쉽게 사용 가능

- 단점: 내부 구조에 대한 통제가 어렵고, 신뢰도에 한계가 있을 수 있음

🧪 실전에서의 튜닝 전략 팁

1. 탐색 범위 지정은 도메인 지식 기반으로

하이퍼파라미터는 무작정 넓은 범위를 탐색하는 것보다, 도메인 지식이나 논문, 사례를 참고해 적절한 범위로 한정하는 것이 효율적입니다.

2. 먼저 중요한 하이퍼파라미터부터 고정

모든 하이퍼파라미터를 한 번에 튜닝하려 하지 말고, 가장 성능에 영향을 주는 몇 개부터 튜닝 후 나머지를 조정하는 방식이 안정적입니다.

3. 교차 검증(Cross Validation) 필수

튜닝된 결과가 특정 데이터셋에만 과적합되지 않도록, 반드시 K-Fold 교차 검증을 통해 일반화 성능을 평가해야 합니다.

4. GPU/TPU 병렬 처리 활용

튜닝은 반복적인 훈련이 필수이므로, 병렬화와 클라우드 자원을 적극 활용하면 시간을 크게 단축할 수 있습니다.

📊 하이퍼파라미터 튜닝과 과적합 방지

튜닝 과정에서 가장 중요한 점은 훈련 성능만이 아니라 검증 성능도 함께 고려해야 한다는 점입니다.

훈련 데이터에서의 성능이 좋아도, 검증 데이터에서는 성능이 떨어지는 경우 과적합이 발생한 것입니다.

- 학습률이 너무 크면: 발산하거나 수렴하지 않음

- 에포크 수가 너무 많으면: 과적합 가능성 증가

- 정규화 항이 너무 강하면: 과소적합 우려

따라서 튜닝 결과는 항상 **학습 곡선(Learning Curve)**을 통해 확인하고, 필요한 경우 조기 종료(Early Stopping) 등의 기법도 함께 적용해야 합니다.

✅ 결론: 전략적으로 접근하자

하이퍼파라미터 튜닝은 머신러닝 프로젝트에서 모델 성능의 마지막 퍼센트를 끌어올리는 핵심 작업입니다.

하지만 무작정 많은 시도를 반복하기보다는, 적절한 전략과 도구를 활용하여 효율적으로 수행하는 것이 중요합니다.

- 초반: 랜덤 서치 또는 그리드 서치로 전체 구조 파악

- 중반: 베이지안 최적화로 유망 영역 집중 탐색

- 후반: 교차 검증과 반복 실험으로 일반화 검증

이러한 단계적 접근법은 모델의 신뢰도와 성능을 극대화할 수 있는 가장 합리적인 전략입니다.

❓ FAQ

Q1. 하이퍼파라미터는 언제 조정하나요?

→ 모델 구조가 확정되고, 데이터 전처리가 완료된 후 본격적으로 조정합니다.

Q2. AutoML만으로 충분하지 않나요?

→ 일반적인 상황에서는 충분하지만, 세밀한 제어가 필요한 프로젝트에는 한계가 있을 수 있습니다.

Q3. 딥러닝에서 중요한 하이퍼파라미터는 무엇인가요?

→ 학습률, 배치 크기, 옵티마이저 종류, 드롭아웃 비율 등이 성능에 큰 영향을 줍니다.

'컴퓨터 비전 & AI > 머신러닝 기초 및 이론' 카테고리의 다른 글

| 머신러닝 모델 평가 지표: 정확도, 정밀도, 재현율 (1) | 2025.05.13 |

|---|---|

| 교차 검증(Cross-Validation)의 개념과 실습 (0) | 2025.05.12 |

| 차원 축소 기법: PCA와 t-SNE 비교 (0) | 2025.05.11 |

| 특성 공학(Feature Engineering)의 중요성과 방법 (1) | 2025.05.11 |

| 머신러닝 모델의 과적합과 과소적합 이해하기 (2) | 2025.05.10 |