AI 모델 배포의 중요성

인공지능(AI) 모델은 학습만큼이나 배포(Deployment) 과정이 중요합니다. 아무리 정확도가 높은 모델이라도 실제 서비스 환경에 안정적으로 배포되지 않으면 실질적인 가치를 제공할 수 없습니다. 특히 운영 환경에서 예측 서비스를 실시간으로 제공하거나, 다양한 사용자 요청을 안정적으로 처리하려면, 체계적인 배포 전략이 필수적입니다.

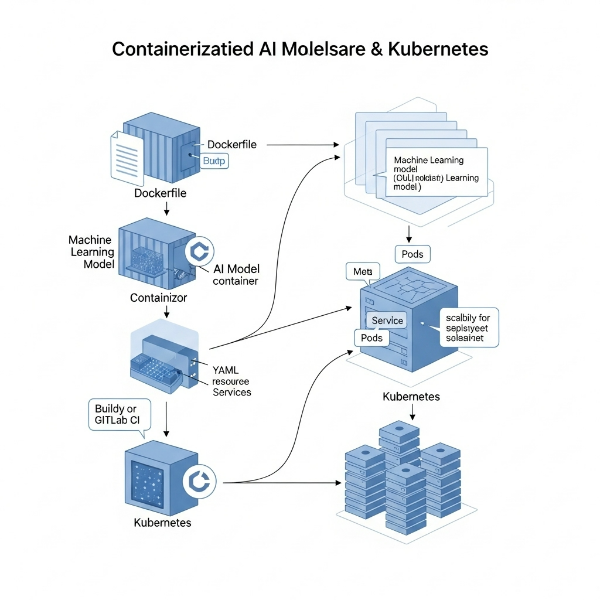

Docker와 Kubernetes는 이러한 AI 모델 배포를 효율적이고 확장 가능하게 관리할 수 있는 핵심 도구입니다. 이 글에서는 Docker와 Kubernetes의 역할을 중심으로, AI 모델을 어떻게 컨테이너화하고 클러스터 환경에서 안정적으로 서비스할 수 있는지 설명합니다.

Docker란 무엇인가?

컨테이너 기반 배포의 핵심

Docker는 애플리케이션과 그 실행 환경을 하나의 이미지로 패키징하여 어디서든 동일하게 실행할 수 있도록 돕는 컨테이너 기술입니다. 전통적인 배포 방식에서는 시스템 간 환경 차이로 인한 문제가 빈번히 발생했지만, Docker를 사용하면 이러한 문제를 효과적으로 해결할 수 있습니다.

AI 모델 배포에 Docker가 적합한 이유

- 모델 실행 환경 일관성 확보

Python 버전, 라이브러리 종속성, OS 차이 등 환경 문제를 방지할 수 있습니다. - 배포 자동화와 단순화

Dockerfile 하나로 전체 모델 실행 환경을 정의하고 자동으로 구축할 수 있습니다. - 경량화된 이미지 제공

가상 머신보다 훨씬 가볍고 빠르게 실행됩니다.

Kubernetes란 무엇인가?

컨테이너 오케스트레이션 플랫폼

**Kubernetes(쿠버네티스)**는 Google에서 시작한 컨테이너 오케스트레이션 시스템으로, 수많은 컨테이너를 자동으로 배포, 확장, 관리할 수 있도록 돕는 플랫폼입니다. 단일 서버가 아닌 다수의 서버에서 AI 서비스를 안정적으로 운영하고자 할 때 Kubernetes는 필수적입니다.

Kubernetes가 제공하는 기능

- 자동 확장(Auto-scaling)

트래픽이 많아지면 자동으로 더 많은 인스턴스를 실행하여 처리 용량을 증가시킵니다. - 자동 복구(Self-healing)

실패한 컨테이너를 자동으로 재시작하거나 다른 노드에서 복제합니다. - 롤링 업데이트(Rolling Update)

무중단 배포가 가능하며, 장애 발생 시 이전 버전으로 롤백할 수 있습니다. - 서비스 디스커버리 및 로드밸런싱

클러스터 내 컨테이너 간 통신과 외부 요청 분산 처리를 자동으로 수행합니다.

Docker를 활용한 AI 모델 패키징

Dockerfile 예시

AI 모델을 Docker 컨테이너로 패키징하려면 Dockerfile을 작성합니다.

FROM python:3.9-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . .

CMD ["python", "serve_model.py"]

이 구조는 간단하지만 강력하며, AI 모델의 서빙 코드와 종속 라이브러리, 학습된 모델 파일 등을 모두 포함할 수 있습니다.

도커 이미지 빌드 및 실행

docker build -t ai-model .

docker run -p 8000:8000 ai-model

이제 로컬이나 서버 어디서든 동일한 환경에서 AI 모델을 실행할 수 있게 됩니다.

Kubernetes를 통한 확장형 AI 배포

1. Docker 이미지 등록

Docker Hub 또는 AWS ECR, Google Container Registry(GCR)와 같은 이미지 저장소에 업로드합니다.

docker tag ai-model myregistry/ai-model:latest

docker push myregistry/ai-model:latest

2. Kubernetes 배포 구성 파일 작성

AI 모델 서비스를 Kubernetes 클러스터에 배포하려면 Deployment와 Service를 정의해야 합니다.

apiVersion: apps/v1

kind: Deployment

metadata:

name: ai-model-deployment

spec:

replicas: 3

selector:

matchLabels:

app: ai-model

template:

metadata:

labels:

app: ai-model

spec:

containers:

- name: ai-model

image: myregistry/ai-model:latest

ports:

- containerPort: 8000

apiVersion: v1

kind: Service

metadata:

name: ai-model-service

spec:

selector:

app: ai-model

ports:

- protocol: TCP

port: 80

targetPort: 8000

type: LoadBalancer

이 설정을 통해 3개의 복제 인스턴스를 생성하고, 외부 요청을 서비스로 라우팅할 수 있습니다.

3. kubectl을 통한 배포 명령어

kubectl apply -f deployment.yaml

kubectl apply -f service.yaml

배포 후 kubectl get pods 명령으로 배포 상태를 확인할 수 있습니다.

AI 모델 배포 시 고려사항

성능 모니터링

Prometheus, Grafana, KubeDash 등을 활용해 모델 추론 지연, 리소스 사용량, 실패율 등을 실시간으로 모니터링해야 합니다.

모델 버전 관리

MLflow나 Seldon, KFServing 등을 Kubernetes와 연계하여 모델 버전 관리 및 A/B 테스트를 구현하면 실무에서 더욱 유용합니다.

보안

Docker 이미지에 **민감한 정보(예: API Key)**를 포함하지 않도록 주의하며, Kubernetes에서는 Secret 및 ConfigMap을 이용해 설정값을 안전하게 관리해야 합니다.

Docker + Kubernetes = AI 서비스 운영의 미래

AI 모델의 정확도만큼이나 중요한 것이 바로 운영 환경에서의 안정성과 확장성입니다. Docker는 환경 일관성과 배포 자동화를 제공하고, Kubernetes는 대규모 확장 및 자동 관리를 통해 실시간 서비스를 안정적으로 운영하게 해줍니다.

AI 기술이 비즈니스 현장에 도입되면서, Docker와 Kubernetes는 이제 선택이 아닌 표준 기술 스택으로 자리 잡고 있습니다. 작은 테스트용 API부터 대규모 추천 시스템까지, AI 모델을 실무에 적용하고자 한다면 이 두 기술을 반드시 이해하고 활용할 필요가 있습니다.

'컴퓨터 비전 & AI' 카테고리의 다른 글

| 금융 산업에서의 머신러닝 적용 (1) | 2025.06.03 |

|---|---|

| 의료 분야에서의 AI 활용 사례 (2) | 2025.06.03 |

| ONNX를 이용한 모델 호환성 확보 (2) | 2025.06.02 |

| MLflow를 통한 머신러닝 실험 관리 (3) | 2025.06.01 |

| AutoML 도구의 개요와 사용법: 인공지능 개발의 자동화를 이끄는 기술 (0) | 2025.06.01 |