워드 임베딩: Word2Vec, GloVe, FastText 비교

📌 서론: 자연어 처리에서 임베딩이란?

자연어 처리(NLP)는 인간의 언어를 컴퓨터가 이해할 수 있도록 가공하는 기술입니다. 그 핵심 중 하나는 바로 단어를 숫자 벡터로 표현하는 방법, 즉 **워드 임베딩(Word Embedding)**입니다. 임베딩은 단어 간 의미적 유사성을 수치화할 수 있도록 돕는 기법으로, NLP의 다양한 작업(분류, 번역, 챗봇 등)에서 필수적인 요소입니다.

본 글에서는 대표적인 워드 임베딩 알고리즘인 Word2Vec, GloVe, FastText의 개념과 차이점을 중심으로 비교 분석합니다.

🧠 워드 임베딩이 필요한 이유

기계는 텍스트를 직접 이해할 수 없기 때문에, 이를 숫자로 변환해야 합니다. 전통적인 방법인 Bag of Words(BoW)나 TF-IDF는 단어의 순서나 의미를 반영하지 못한다는 단점이 있습니다.

반면 워드 임베딩은 다음과 같은 장점이 있습니다:

- 의미 기반 표현: 비슷한 의미의 단어는 가까운 벡터 위치에 존재

- 연산 가능성: "king - man + woman = queen"과 같은 연산이 가능

- 차원 축소: 대규모 텍스트를 효율적으로 표현

🔍 Word2Vec: 단어의 맥락에서 의미를 찾다

✅ Word2Vec의 개요

Word2Vec은 구글이 개발한 임베딩 알고리즘으로, 대규모 텍스트에서 단어의 의미를 벡터로 학습합니다. 이 모델은 크게 두 가지 구조를 사용합니다:

- CBOW (Continuous Bag of Words): 주변 단어로 중심 단어를 예측

- Skip-gram: 중심 단어로 주변 단어를 예측

✅ Word2Vec의 특징

- 맥락 기반 학습: 단어의 주변 단어를 고려해 의미를 학습

- 의미적 유사성 표현: 유사한 단어들이 비슷한 벡터를 가짐

- 고속 학습: 하이퍼파라미터 조정 시 빠르게 수렴

✅ Word2Vec의 단점

- Out-of-Vocabulary 문제: 학습되지 않은 단어는 벡터화 불가

- 형태소 구조 미반영: 단어 내부의 철자 정보 무시

🔍 GloVe: 통계 기반의 글로벌 접근

✅ GloVe의 개요

**GloVe (Global Vectors for Word Representation)**는 스탠포드 대학에서 개발한 워드 임베딩 알고리즘입니다. Word2Vec이 지역적인 맥락을 활용한 반면, GloVe는 단어 간의 동시 등장 확률 통계를 전역적으로 활용합니다.

✅ GloVe의 특징

- 전역 통계 활용: 전체 말뭉치에서의 단어 간 관계 학습

- 단어 간 유사성 연산 가능: 벡터 간 거리로 의미 유사도 측정

- 정적 임베딩 제공: 사전 훈련된 벡터 사용 가능

✅ GloVe의 단점

- 형태 정보 손실: 단어 철자 및 구성 요소 반영 안됨

- 문맥 변화 반영 어려움: 단어가 사용된 문맥에 따라 의미 변화를 포착하기 어려움

🔍 FastText: 단어 내부 구조까지 반영

✅ FastText의 개요

FastText는 페이스북 AI 연구팀에서 개발한 알고리즘으로, 단어를 벡터로 바꾸는 과정에서 **단어를 구성하는 subword(부분 문자 n-gram)**까지 고려합니다. 예를 들어 "apple"이라는 단어는 "app", "ppl", "ple" 등 여러 서브워드로 분해됩니다.

✅ FastText의 특징

- 형태소 기반 학습: 단어 내부 구조를 반영하여 유사 단어 학습 가능

- OOV 문제 최소화: 새로운 단어도 subword 조합으로 임베딩 가능

- 다국어 지원에 유리: 다양한 언어 구조에 적합

✅ FastText의 단점

- 학습 시간 증가: subword까지 학습하므로 모델 학습에 더 많은 자원 필요

- 단어 수준 의미 연산 한계: 전체 문맥보다는 부분 정보에 초점

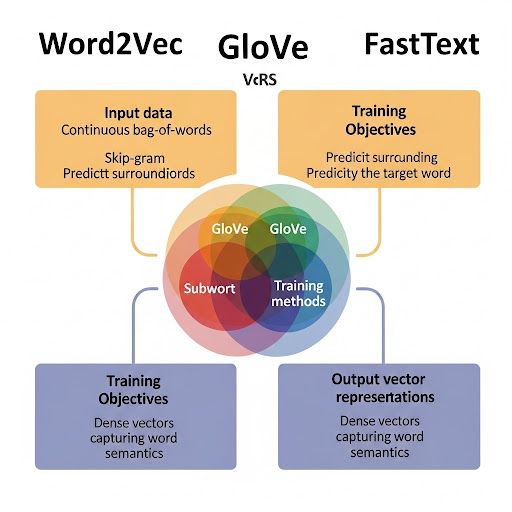

⚖️ Word2Vec vs GloVe vs FastText

✅ 비교 요약

- Word2Vec: 문맥 기반, 빠름, 형태 정보는 미포함

- GloVe: 전역 통계 기반, 의미 연산에 강함, 문맥 변화에 약함

- FastText: 철자 기반 subword 반영, OOV 처리 우수, 다국어에 유리

각 모델은 장단점이 분명하므로, 사용 목적에 따라 선택이 중요합니다.

🧪 워드 임베딩의 실제 활용 분야

✅ 텍스트 분류

이메일 스팸 필터링, 뉴스 기사 분류 등에 워드 임베딩이 적용되어 문장 특징을 벡터로 변환해 분류 정확도를 높입니다.

✅ 감정 분석

리뷰나 소셜 미디어 글을 분석할 때, 감정 단어 간 의미 관계를 파악하는 데 임베딩이 효과적입니다.

✅ 기계 번역

단어 간 유사성 및 관계를 기반으로 번역의 품질을 높이는 데 사용됩니다.

✅ 챗봇 응답 생성

사용자의 발화를 벡터화하여 유사한 문맥을 탐색하고, 적절한 응답을 생성하는 데 기여합니다.

🛠️ 워드 임베딩 모델 적용 팁

- 도메인 데이터에 맞춘 훈련: 일반적으로 제공되는 사전 훈련된 모델보다는, 도메인에 맞춰 재학습하면 성능이 향상됩니다.

- 차원 수 조절: 벡터의 차원이 너무 높으면 계산량 증가, 너무 낮으면 표현력 저하 — 적정 차원(100~300)을 선택해야 합니다.

- OOV 단어 대비: FastText와 같은 subword 기반 모델을 활용하여 유연성을 높일 수 있습니다.

🔚 결론: 임베딩 모델 선택은 프로젝트 성격에 따라

Word2Vec, GloVe, FastText는 각각의 알고리즘적 특성과 목적에 따라 다르게 작동합니다.

단순하고 빠른 벡터화가 필요하다면 Word2Vec, 의미 연산 중심이면 GloVe, 복잡한 언어나 신조어 처리까지 고려해야 한다면 FastText가 적합합니다.

NLP 프로젝트의 성격에 따라 올바른 임베딩 모델을 선택하면 정확도와 효율성을 모두 높일 수 있습니다.