딥러닝에서의 정규화 기법: Dropout과 Batch Normalization

✅ 딥러닝 정규화란 무엇인가?

딥러닝 모델은 매우 복잡하고 수많은 파라미터를 가지기 때문에 과적합(overfitting) 되기 쉽습니다. 과적합이란 학습 데이터에는 높은 정확도를 보이지만, 새로운 데이터에 대해서는 일반화 성능이 떨어지는 현상입니다.

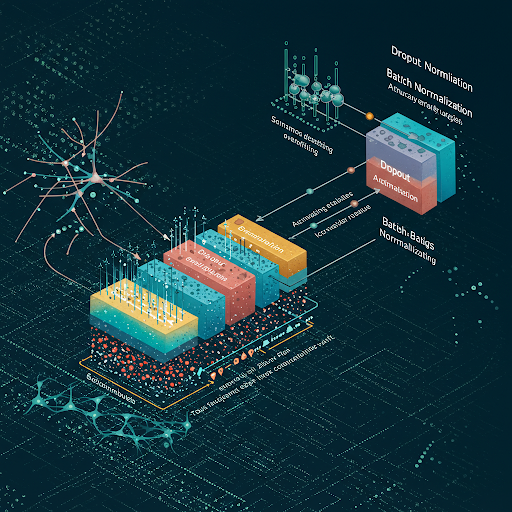

이를 해결하기 위해 정규화(regularization) 기법이 사용됩니다. 정규화는 모델이 학습 도중 너무 특정한 패턴에 집착하지 않도록 규제하는 방법입니다. 오늘날 대표적인 정규화 기법으로는 Dropout과 Batch Normalization이 있으며, 이 두 방법은 거의 모든 현대 딥러닝 아키텍처에서 필수적으로 사용됩니다.

🔍 Dropout: 뉴런의 무작위 생존 전략

📌 Dropout의 개념

Dropout은 학습 도중 뉴런을 무작위로 제거(또는 비활성화)하는 방식입니다. 학습할 때마다 일부 뉴런의 출력을 0으로 만들고, 이로 인해 특정 뉴런에 과도하게 의존하지 않게 되어 일반화 성능이 향상됩니다.

이 기법은 과적합을 방지하고 학습이 좀 더 견고하게 이루어지도록 만들어줍니다.

🧠 왜 효과적인가?

Dropout은 마치 여러 개의 다른 신경망을 앙상블로 학습하는 효과를 줍니다. 뉴런들이 랜덤하게 꺼지면서 매번 다른 경로로 정보가 전달되기 때문에, **특정 뉴런에 의존하는 현상(공동 적응, co-adaptation)**을 방지할 수 있습니다.

💡 Dropout의 적용 위치

- 은닉층(hidden layer): 가장 일반적인 적용 위치

- 입력층(input layer): 경우에 따라 가능하지만, 정보 손실 우려

- 출력층(output layer): 잘 사용하지 않음

🔧 Dropout 사용 시 주의점

- 학습 시에만 적용되며, 추론(inference) 시에는 적용되지 않음

- 추론 시에는 드롭된 뉴런의 영향을 보정하기 위해 출력을 스케일링(보통 1/p)

📊 Batch Normalization: 내부 공변량 변화 해결

📌 Batch Normalization이란?

**Batch Normalization(BN)**은 각 층의 입력을 정규화하여, 평균이 0이고 표준편차가 1이 되도록 변환하는 기법입니다. 이 과정을 통해 모델의 학습 안정성을 높이고 수렴 속도를 향상시킵니다.

이 기법은 딥러닝의 학습을 더 빠르게 하고, 초기값 설정에 덜 민감하게 만들며, 일반화 성능도 향상시키는 장점이 있습니다.

📉 내부 공변량 변화란?

신경망의 층이 깊어질수록, 앞단의 파라미터 변화가 뒷단에 큰 영향을 미쳐 학습이 불안정해집니다. 이를 **내부 공변량 변화(Internal Covariate Shift)**라고 합니다. BN은 이를 완화시켜 더 깊은 네트워크의 안정적 학습을 가능하게 합니다.

🧪 BatchNorm의 작동 방식

- 각 배치에서 평균과 분산을 계산

- 정규화(normalization): 평균을 0, 분산을 1로 맞춤

- 스케일과 이동: 학습 가능한 파라미터 γ, β를 통해 원래의 표현력을 유지

⚙️ 적용 위치

- 보통 활성화 함수(ReLU 등) 앞이나 뒤에 적용

- CNN에서는 convolution 연산 후 적용

🧩 Dropout과의 차이점

| 구분 | Dropout | BatchNorm |

| 목적 | 과적합 방지 | 학습 안정화 및 수렴 속도 향상 |

| 방식 | 뉴런 무작위 제거 | 입력 정규화 |

| 사용 시점 | 학습 시만 적용 | 학습 및 추론 모두 |

| 성능 영향 | 일반화 향상 | 수렴 속도 + 일반화 |

🤝 Dropout과 Batch Normalization의 조합

두 정규화 기법은 서로 보완적인 관계입니다. Dropout은 과적합을 억제하고 일반화 성능을 높이며, BatchNorm은 학습을 안정적으로 만들고 빠르게 수렴하도록 도와줍니다.

하지만 일부 논문에서는 BatchNorm을 사용할 경우 Dropout이 필요하지 않거나, 오히려 성능을 저해할 수 있음을 주장하기도 합니다. 따라서 모델 구조와 데이터셋의 특성을 고려하여 적절히 조합하거나 선택적으로 적용하는 것이 중요합니다.

🧠 실제 사례로 보는 정규화 기법

✅ CNN 이미지 분류

- ResNet, VGG, Inception 등에서는 대부분 BatchNorm을 필수적으로 사용

- 과적합 가능성이 높을 때는 Dropout을 일부 층에 적용하여 보완

✅ NLP Transformer 모델

- 대부분 Dropout 사용

- BatchNorm보다는 Layer Normalization을 선호 (특히 BERT, GPT 등)

🔧 구현 시 팁

PyTorch 예시

import torch.nn as nn

model = nn.Sequential(

nn.Linear(512, 256),

nn.BatchNorm1d(256),

nn.ReLU(),

nn.Dropout(p=0.5),

nn.Linear(256, 10)

)

TensorFlow 예시

from tensorflow.keras.layers import Dense, BatchNormalization, Dropout

model = tf.keras.Sequential([

Dense(256, input_shape=(512,)),

BatchNormalization(),

tf.keras.layers.Activation('relu'),

Dropout(0.5),

Dense(10, activation='softmax')

])

❓ 자주 묻는 질문 (FAQ)

Q1. Dropout은 학습 중에만 적용되나요?

네. Dropout은 학습 중에는 무작위로 뉴런을 비활성화하지만, 추론 시에는 전체 뉴런을 사용하며 출력을 조정합니다.

Q2. BatchNorm은 추론 시에도 필요한가요?

네. 학습 중 계산된 이동 평균(mean)과 분산(variance)을 사용하여 정규화를 수행합니다. 추론 시에도 적용되므로 꼭 유지해야 합니다.

Q3. 두 기법을 동시에 사용해도 되나요?

가능합니다. 하지만 데이터, 네트워크 구조에 따라 성능에 미치는 영향이 달라질 수 있으므로 실험적으로 확인하는 것이 좋습니다.

🔚 결론: 정규화는 현대 딥러닝의 필수 요소

딥러닝 모델을 학습할 때, 단순히 모델 아키텍처를 잘 설계하는 것만으로는 부족합니다. Dropout과 Batch Normalization과 같은 정규화 기법을 적절히 활용해야 학습 속도, 안정성, 일반화 성능을 모두 확보할 수 있습니다.

이 두 가지는 각자의 방식으로 학습을 규제하며, 딥러닝의 다양한 문제 해결에 핵심적인 역할을 하고 있습니다.