딥러닝 모델의 학습률 조정 전략

🧠 학습률이란 무엇인가?

딥러닝에서 모델을 학습시킬 때 가장 핵심적인 하이퍼파라미터 중 하나는 **학습률(Learning Rate)**입니다. 학습률은 경사하강법(Gradient Descent) 기반 최적화 알고리즘에서 가중치를 얼마나 빠르게 업데이트할지를 결정하는 값으로, 너무 크면 발산하고 너무 작으면 수렴 속도가 지나치게 느려질 수 있습니다.

딥러닝 모델의 성능은 학습률의 설정에 따라 크게 달라지며, 효율적인 학습률 조정은 수렴 속도 향상, 안정적인 학습, 더 높은 정확도 달성에 직결됩니다.

📈 학습률이 모델 학습에 미치는 영향

1. 학습률이 너무 클 경우

- 손실 함수가 최솟값에 도달하지 못하고 튕겨 나가며 발산

- 학습 불안정 또는 완전 실패 가능

- 정확도 하락, 훈련 중 Nan 오류 발생

2. 학습률이 너무 작을 경우

- 학습 속도가 너무 느려 시간 낭비

- 지역 최솟값에 갇힐 가능성

- 충분한 학습이 이루어지지 않음

따라서 학습률은 모델이 안정적으로, 빠르게 수렴하면서도 최적 성능에 도달하게 하는 핵심 변수입니다.

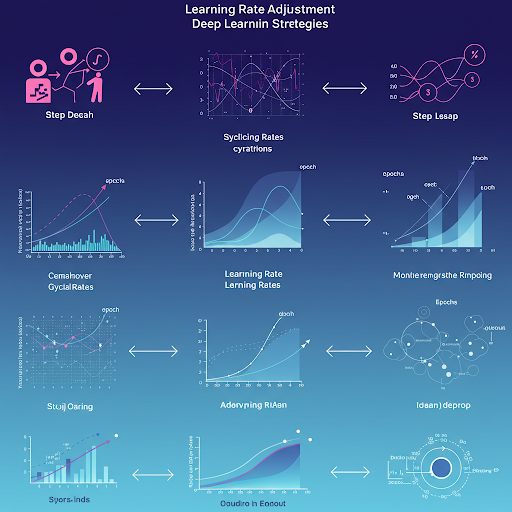

⚙️ 대표적인 학습률 조정 전략

🔹 1. 고정 학습률 (Fixed Learning Rate)

가장 간단한 방식으로, 학습률을 일정하게 유지합니다. 하지만 전체 학습 기간 동안 동일한 비율로 가중치를 조정하므로, 초반엔 빠르게 학습되지만 후반부엔 과도한 업데이트로 최적값을 놓칠 수 있습니다.

사용 예: optimizer = SGD(lr=0.01)

🔹 2. 스텝 감소 (Step Decay)

일정 에폭(epoch)마다 학습률을 일정 비율로 줄이는 방법입니다. 보통은 10, 20, 30 에폭마다 감소시키며, 계단 형태로 변화합니다.

예: 매 10 에폭마다 학습률을 0.1배로 감소

장점은 구현이 쉽고, 성능 향상 가능성이 크며, 특히 CNN 학습에 자주 사용됩니다.

🔹 3. 지수 감소 (Exponential Decay)

학습이 진행될수록 지수 함수 형태로 학습률을 줄이는 방법입니다. 훨씬 부드럽게 감소하여 학습의 안정성을 높일 수 있습니다.

공식: lr = initial_lr * exp(-k * epoch)

TensorFlow와 PyTorch에서는 해당 스케줄러를 기본적으로 지원합니다.

🔹 4. 시간 기반 감소 (Time-based Decay)

지수 감소보다 더 완만하게 감소시키는 방법으로, 주로 간단한 모델에 적용됩니다.

공식: lr = initial_lr / (1 + k * epoch)

하지만 복잡한 모델에서는 학습률이 너무 느리게 줄어드는 문제가 있습니다.

🔹 5. 적응형 학습률 (Adaptive Learning Rate)

학습 과정에서 자동으로 학습률을 조정하는 전략입니다. 대표적으로는 AdaGrad, RMSprop, Adam 등이 있습니다.

- AdaGrad: 빈번한 업데이트가 일어나는 가중치는 점점 작은 학습률로 조정

- RMSprop: 학습률을 최근 기울기 변화에 따라 적절히 조정

- Adam: 모멘텀과 적응형 학습률의 장점을 모두 결합

이러한 옵티마이저들은 손실이 빨리 수렴하고, 비교적 학습률 조정이 자동으로 일어나기 때문에 많이 사용됩니다.

🔹 6. 사이클링 학습률 (Cyclical Learning Rate, CLR)

학습률을 주기적으로 높이고 낮추는 방식으로, 지역 최적점에 갇히는 것을 방지하고 일반화 성능을 향상시키는 데 효과적입니다.

- 삼각 파형 또는 사인 곡선 형태로 변화

- 초기 학습률, 최대 학습률, 사이클 길이 등을 설정

FastAI 프레임워크나 Keras에서도 쉽게 구현할 수 있습니다.

🔹 7. Warm-up 전략

초기 학습 단계에서는 모델이 급격히 발산하는 경우가 많습니다. 이를 방지하기 위해, 처음 몇 에폭 동안 학습률을 서서히 증가시키고 이후 일정하게 유지하거나 감소시키는 방식입니다.

주로 Transformer, BERT 등의 대형 모델 학습에서 필수적으로 사용됩니다.

🧪 실전에서의 학습률 조정 예시

예시 1: CNN 이미지 분류 모델 (ResNet)

- 초기 학습률: 0.1

- 30, 60, 90 에폭마다 0.1배로 감소 (Step Decay)

- 최종 정확도 상승

예시 2: 자연어 처리 모델 (BERT Fine-tuning)

- Warm-up: 처음 10% 구간 동안 0 → 0.00005까지 증가

- 이후 Linear Decay로 감소

- 과적합 방지와 안정적인 수렴

🔍 학습률 찾는 실험적 기법: Learning Rate Finder

FastAI와 PyTorch에서는 학습률을 실험적으로 탐색할 수 있는 LearningRateFinder 도구를 제공합니다. 이 기법은 여러 학습률로 학습을 진행하면서 손실이 가장 빠르게 감소하는 구간을 찾아줍니다.

시각적으로 그래프를 확인해 최적 학습률을 선택 가능

이 기법을 활용하면 최적의 초기 학습률을 감으로 설정하는 대신, 데이터 기반으로 설정할 수 있어 매우 유용합니다.

⚠️ 학습률 설정 시 주의할 점

- 데이터 스케일: 데이터의 정규화 여부에 따라 최적 학습률이 달라질 수 있음

- 배치 크기와의 관계: 일반적으로 큰 배치 크기에서는 더 큰 학습률이 효과적

- 모델 구조에 따라 다름: 단순한 CNN과 Transformer는 서로 다른 전략이 필요

❓ FAQ: 학습률 조정 관련 자주 묻는 질문

Q1. 학습률을 자동으로 조절할 수 있나요?

네, 대부분의 딥러닝 프레임워크에서 ReduceLROnPlateau, Scheduler, OneCycleLR 같은 기능을 통해 자동 조절이 가능합니다.

Q2. Adam과 같은 옵티마이저를 쓰면 따로 조정이 필요 없나요?

기본적으로 자동 조정 기능이 있지만, 여전히 초기 학습률 설정이 중요합니다. 학습률이 너무 크면 발산할 수 있습니다.

Q3. 학습률이 고정이면 안 좋은가요?

간단한 문제에서는 괜찮을 수 있지만, 학습률 감소 전략을 활용하는 것이 일반적으로 더 좋은 성능을 보입니다.

✅ 결론: 성공적인 딥러닝 학습을 위한 핵심 전략

딥러닝 모델의 학습 성능을 극대화하려면 단순히 좋은 모델 아키텍처를 사용하는 것만으로는 부족합니다. 학습률의 설정과 조정 전략은 모델 수렴 속도, 최종 정확도, 안정성에 중대한 영향을 끼칩니다. 실험적 방법과 스케줄링 전략을 적절히 활용한다면, 더 적은 자원으로 더 우수한 성능을 얻을 수 있습니다.